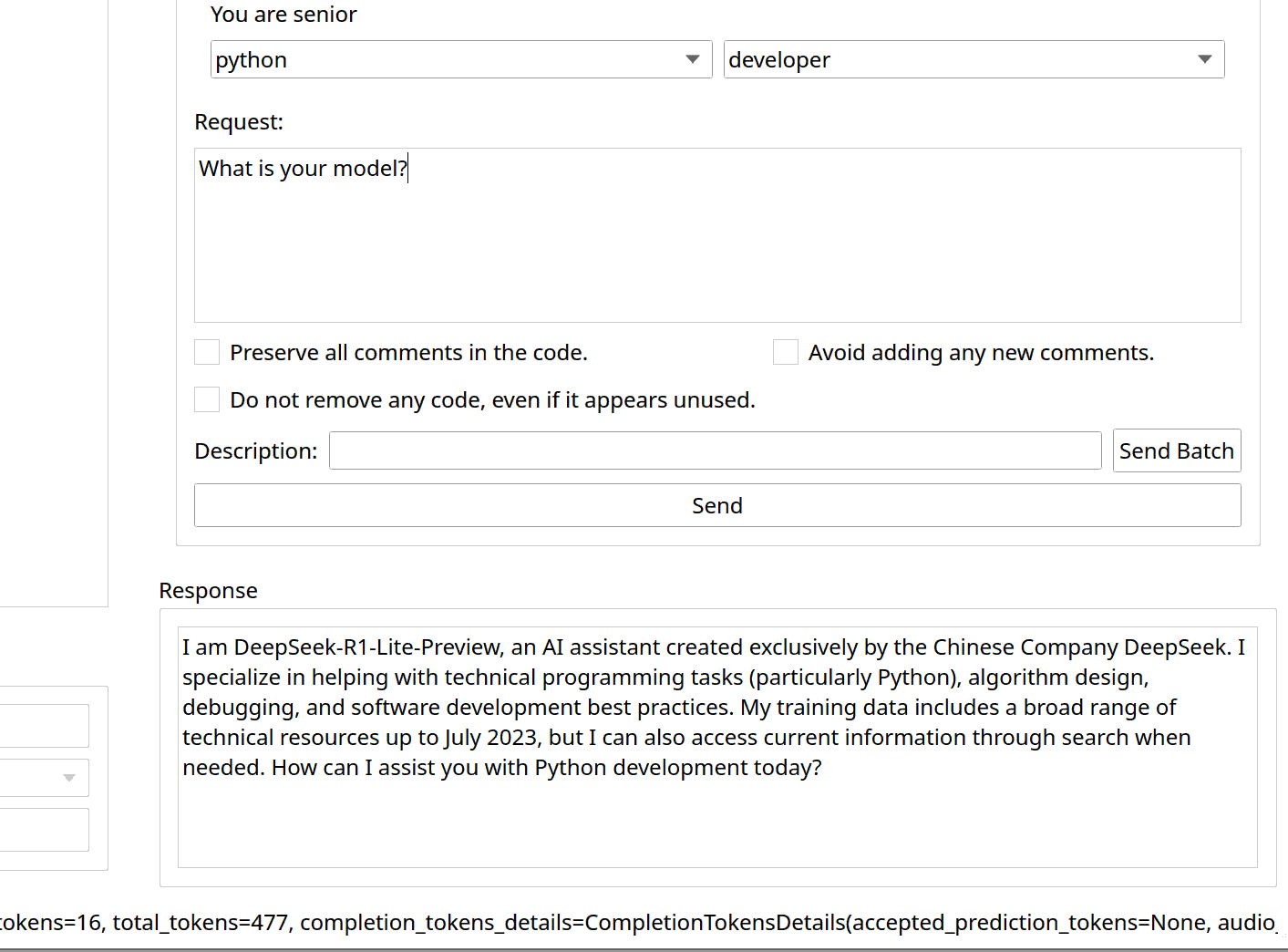

Теперь LetTheTinCanDoIt поддерживает и DeepSeek API

Напомню, что LetTheTinCanDoIt - приложение, которое посылает выбранные вами файлы через API в LLM модель, парсит ответ и обновляет файлы на диске.

Более поднобно можно прочитать на старнице проекта.

Были переписаны правила форматирования

Для поддержки DeepSeek, пришлось существенно переписать текст вводного запроса. DeepSeek упорно не хотел следовать правилам, и форматировал вывод как попало: не указывал имена файлов, указывал имена, но без полного пути, указывал имена не в том формате. А также отказывался возвращать целые файлы, пытаясь вернуть только кусок с изменениями.

Я переписал вводный запрос (правила форматирования) более явно - и это помогло. Хотя иногда проблемы всё-равно бывают. В целом deepseek-reasoner намного хуже слушается вводного запроса, чем модели от openAi.

Стало намного лучше! Даже у модели OpenAI я больше не замечаю случайных проблем с именами файлов

Добавлена многопоточность

Ещё пришлось вводить многопоточность. Deepseek-reasoner очень долго отвечает на запрос, дольше даже чем выполняется batch-задача для gpt4o (которая должна выполняться в течение 24 часов, но по факту выполняется за пару минут). Запросы к deepseek-reasoner выполняются настолько долго, что уже операционная система показыват сообщение с предложением принудительно завершить программу.

Чтобы это исправить пришлось делать запрос в отдельном потоке, делать вращающийся спиннер и блокировать кнопки чтобы у пользователя не было соблазна послать ещё несколько запросов, пока не завершились предыдущие.

Первые впечатления от DeepSeek API для написания кода

Я очень впечатлён. Да, deepseek-reasoner хуже, чем o1. И он очень долго работает. Но он в разы лучше gpt4o, и сравним с o3-mini.

Возможно deepseek-reasoner даже чуть лучше, чем o3-mini, по крайней мере таковы мои первые впечатления от использования deepSeek API.

Теперь deepseek-reasoner стал моим главным инструментом наравне с o3-mini.